Вернуться к блогу

В будущем большие языковые модели окончательно перейдут из статуса экспериментальных технологий в инфраструктурный слой цифровой экономики. Уже сегодня компании используют их не только для общения с клиентами, но и для аналитики, планирования и автоматизации сложных задач. Современные языковые модели становятся связующим звеном между данными, людьми и автоматизированными системами, меняя подходы к работе с информацией и знаниями.

Термин «галлюцинации» применительно к LLM обозначает случаи, когда модель генерирует правдоподобный, но фактически неточный или вымышленный контент. Несмотря на активные исследования и технологические усилия по снижению частоты таких ошибок, галлюцинации сохраняются как фундаментальный недостаток архитектур генеративных моделей. Языковые модели склонны уверенно формулировать ответы даже в условиях нехватки данных, что особенно критично там, где цена ошибки высока.

Ключевой источник проблемы — математическая природа моделей: оптимизация на прогноз следующего токена при недостатке контекстуальных знаний неизбежно приводит к заполнению информационных пробелов статистическими догадками. Эта характеристика архитектуры делает полное устранение галлюцинаций недостижимым в строгом смысле, даже при усилении механизмов проверки и внешнего подкрепления.

Большие языковые модели (LLM) значительно расширяют возможности автоматизации и интеллектуальной поддержки при разработке ПО.

LLM позволяют разработчикам быстро создавать рабочие куски кода прямо из обычного описания задачи, снижая нагрузку и ускоряя разработку. Они также помогают анализировать и разъяснять чужой код, что повышает эффективность работы над сложными проектами и изучение новых технологий.

Они автоматически находят ошибки и подсказывают варианты исправлений, улучшая как производительность, так и читаемость кода. А также берут на себя рутинные дела, создавая тесты, шаблоны и документацию, освобождая разработчиков для более интересных и важных задач.

Еще одно перспективное направление — автоматический перевод кода между разными языками программирования. LLM способны адаптировать алгоритмы и структуры данных под синтаксис другого языка, что существенно облегчает миграцию проектов и интеграцию с новыми технологиями.

Современные большие языковые модели (LLM) основаны на ряде фундаментальных принципов, которые определяют их эффективность и универсальность.

Обработка последовательностей. Модель анализирует не только отдельные слова, но и их взаимосвязь в предложении или абзаце.

Внимание к контексту (Self-Attention). Каждое слово оценивается с учетом окружающих его слов — так модель «понимает» смысл фразы.

Глубокое обучение (Deep Learning). Многослойные нейронные сети выявляют сложные закономерности в текстах.

Обобщение знаний. После обучения на большом объеме данных модель способна применять полученные знания к новым задачам.

Именно благодаря этим принципам большие языковые модели могут не только оперировать фактами из обучающего материала, но и рассуждать, делать предположения и создавать осмысленные тексты на самые разные темы.

Существующие подходы, включая Retrieval-Augmented Generation (RAG), цепочки рассуждений и внешние проверяющие механизмы, демонстрируют значительное снижение частоты ошибочных выводов на прикладных задачах. Однако ни один из них не ликвидирует ошибочные выводы в принципе. Галлюцинации останутся системной характеристикой LLM, требующей специализированных стратегий управления рисками в критичных приложениях, а не «узким техническим недостатком», который может быть полностью устранен. Основной вектор развития связан не с «перевоспитанием» самой модели, а с ее окружением. Языковые модели все чаще работают не в изоляции, а в связке с внешними источниками.

В этом контексте решающую роль начинают играть базы знаний, которые позволяют проверять факты, уточнять контекст и снижать долю вымышленных ответов. Вместо абстрактной генерации текста модель опирается на структурированные данные и корпоративные хранилища.

При этом важно понимать, что галлюцинации не исчезнут полностью. Они будут сохраняться в ситуациях, где модель вынуждена рассуждать без опоры на данные или при неоднозначных запросах. Но для большинства прикладных сценариев риск станет приемлемым и прогнозируемым. Особенно это заметно в корпоративной среде, где чат-боты и аналитические помощники работают в строго заданных рамках и сценариях.

На практике снижение галлюцинаций будет обеспечиваться за счет следующих составляющих:

внедрения контекста;

пополнения источников;

регулярного контроля.

В будущем вопрос галлюцинаций сместится из плоскости «недостаток технологии» в плоскость «качество архитектуры решения». Те, кто грамотно выстроит связку LLM и структуру знаний, получат стабильный и доверенный инструмент.

Fine-tuning, как классический метод адаптации предобученных моделей под узкоспециализированные задачи путем дополнительного обучения, сохраняет свою ценность, но теряет доминирующую позицию в стратегиях адаптации LLM.

Во-первых, наблюдается устойчивый сдвиг к гибридным и модульным подходам. Комбинации retrieval-based систем, контекстуальных адаптаций и адаптивных контролирующих слоев обеспечивают более гибкое обновление знаний без полного повторного обучения весов модели. Такие методы позволяют оперативно интегрировать свежие данные или корпоративные знания без дорогостоящего фазы fine-tuning.

Во-вторых, специализированные стратегии снижения галлюцинаций, которые выходят за рамки простого переобучения (например, структурированные выходные формы или семантические фильтры), демонстрируют лучшие результаты, чем стандартное fine-tuning на узких датасетах.

Вместо дообучения моделей под каждую задачу компании будут все чаще использовать контекстную адаптацию, плагины и подключение сторонних данных. Это упростит обновление логики моделей и снизит затраты на обслуживание. Языковые модели LLM станут универсальными ядрами, а специализация будет происходить на уровне данных и сценариев применения. Такая стратегия эффективна и перспективна для каждого отдельного звена, если они будут работать в слаженной связке друг с другом.

В ближайшем году безопасность окончательно перестанет быть дополнительным слоем вокруг LLM. Языковые модели будут рассматриваться как критическая цифровая инфраструктура, напрямую работающая с чувствительной информацией и влияющая на управленческие решения. Это автоматически повышает требования к контролю, прозрачности и управляемости таких систем.

Фокус смещается с мощности моделей на условия их эксплуатации. Ключевым становится вопрос: можно ли встроить LLM в бизнес так, чтобы они не нарушали существующие контуры безопасности и ответственности.

По мере перехода LLM из пилотных проектов в производственные системы компании все чаще будут отказываться от универсальных публичных моделей в пользу локальных и гибридных развертываний. Причина проста: открытые решения сложно адаптировать под внутренние политики доступа, требования регуляторов и реальные бизнес-риски.

Локальные и hybrid-подходы позволяют сохранить контроль над данными, исключить их неконтролируемую передачу во внешние контуры и встроить ИИ в существующую ИТ-архитектуру без компромиссов по безопасности. Это не усложнение, а шаг к предсказуемому и масштабируемому использованию LLM.

Ключевая зона внимания — не сама модель, а то, как она получает доступ к данным и в каком контексте формирует ответы. Важную роль здесь будут играть корпоративные базы знаний и управляемые источники информации.

В отличие от классического обучения или передачи сырых данных в модель, такие подходы позволяют:

жестко ограничивать допустимый контекст;

фиксировать источники информации;

воспроизводить логику ответа при аудите.

В результате поведение LLM становится более предсказуемым: модель работает не в абстрактном пространстве знаний, а в строго заданных рамках бизнес-контекста. Это снижает риски утечек и повышает доверие к результатам генерации.

Отдельный тренд — интеграция языковых моделей без ломки существующих систем безопасности. Для зрелых организаций это критично: ИИ уже влияет на операционные процессы, аналитику и принятие решений.

Чем глубже внедрение LLM, тем выше требования к:

аудиту действий модели;

детальному логированию запросов и ответов;

соответствию отраслевым и регуляторным нормам.

Отсутствие этих механизмов будет рассматриваться не как временное ограничение, а как операционный риск, сопоставимый с ошибками в финансовых или управленческих системах.

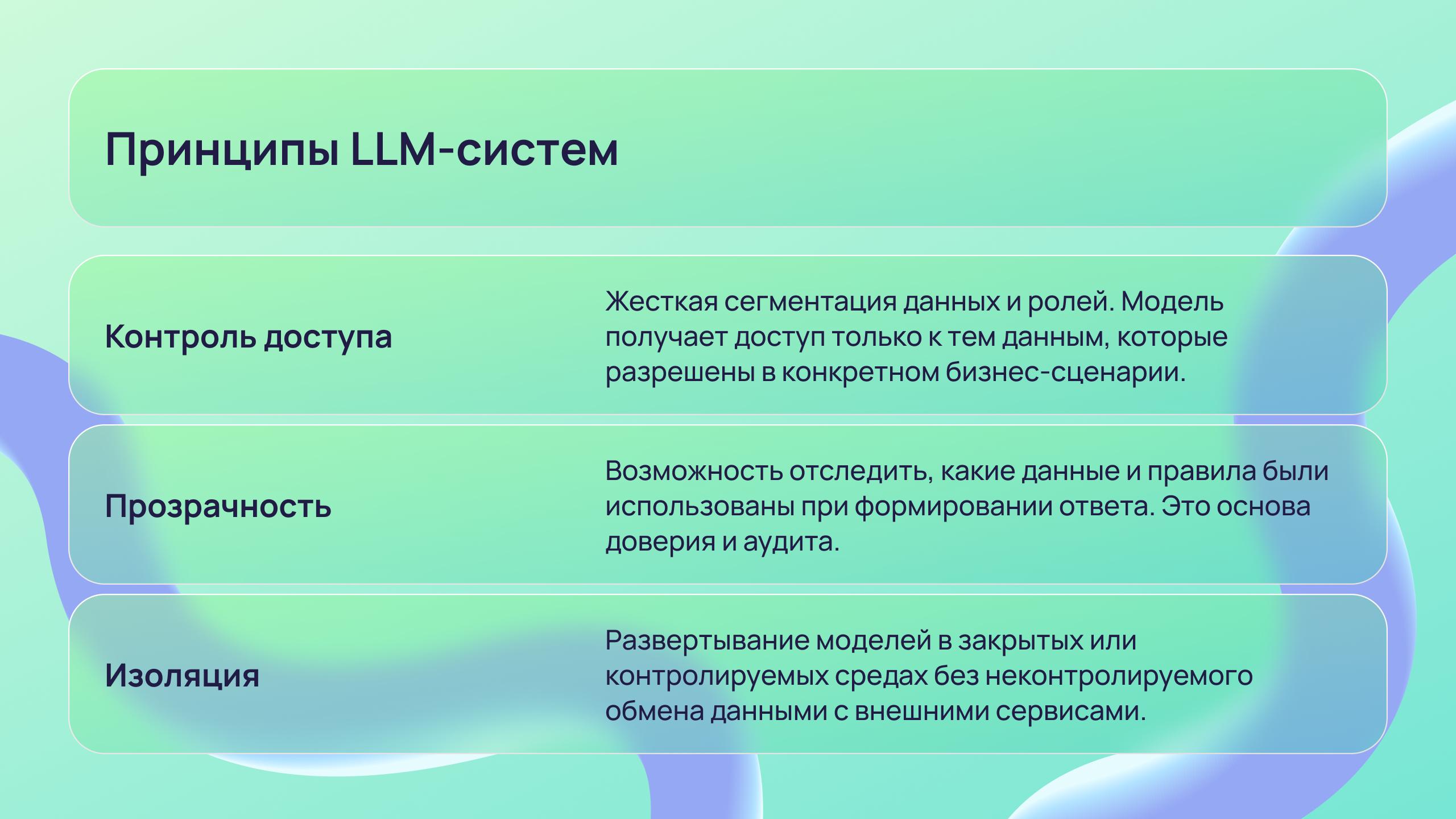

Практика показывает, что устойчивые LLM-системы строятся вокруг нескольких принципов:

В результате безопасность перестает восприниматься как фактор, тормозящий развитие LLM. Напротив, она становится условием их масштабного применения. Там, где выстроены контроль, прозрачность и управляемость, языковые модели быстрее переходят из экспериментов в рабочие системы.

Это напрямую влияет на эффективность производства, планирования и управления процессами. LLM начинают работать не как инструмент «для попробовать», а как полноценная часть цифровой инфраструктуры бизнеса.

Исследовательская и практическая эволюция AI-агентов демонстрирует переход от простых автоматизированных скриптов к многоуровневым, автономным системам, способным решать сложные прикладные задачи и координировать многошаговые процессы. Этот сдвиг подтверждается несколькими тематическими обзорами и оригинальными исследованиями, которые систематизируют достижения по архитектурам, применению и ограничениям агентских систем на базе крупных языковых моделей (LLM).

Обзор Wang et al. (2024) в Frontiers of Computer Science систематизирует современное состояние LLM-агентов, подчеркивая их модульную архитектуру, необходимость управления многозадачностью и взаимодействия с внешними инструментами — все это фундаментальные требования к построению автономных рабочих систем, а не разрозненных «ассистентов».

Исследование Sapkota предлагает концептуальную таксономию AI-агентов и agentic AI, разделяя их по степени автономии, использованию инструментов и координации действий. В нем выделены ключевые архитектурные направления: интеграция планирования, распределенной памяти, декомпозиции задач и многомодального взаимодействия, которые становятся обязательными компонентами агентских систем. Современные исследованию по самоуправляемым лабораториям демонстрируют, что агентные архитектуры выходят за пределы цифрового текста и интегрируются в физическую автоматизацию. Архитектура k-agents, примененная к квантовой вычислительной лаборатории, позволяет агентам не только планировать и исполнять экспериментальные шаги, но и управлять ими в режиме непрерывного циклического контроля, обеспечивая обратную связь и адаптацию в процессе работы.

Использование больших языковых моделей в науке перестанет ограничиваться вспомогательными задачами и перейдет к интеграции в ключевые этапы научного процесса. LLM становятся не просто инструментом написания текста или поиска литературы, а элементом, влияющим на формулирование гипотез, проектирование экспериментов, анализ данных и интерпретацию результатов.

Одно из крупнейших направлений исследований — использование LLM для генерации новых гипотез. Анализ показывает, что современные модели способны синтезировать идеи, которые выходят за пределы прямого извлечения существующей информации и предлагают новые направления для проверки. Работа по генерации гипотез в биомедицине продемонстрировала, что языковые модели могут создавать новые и верифицируемые гипотезы, даже на данных, которые не использовались при их обучении, особенно в сочетании с инструментами для оценки неопределенности и мультиагентной генерации идей.

В другом исследовании предложена методика Knowledge Grounded Chain of Ideas (KG-CoI), которая улучшает точность генерации гипотез за счет структурированного внешнего знания и выявления ошибок модели. Это показывает, что объединение LLM с формальными знаниями снижает риски ложных выводов и делает результаты пригодными для научного использования.

Обширное аналитическое исследование по генерации и валидации гипотез в научных исследованиях подчеркивает, что современные LLM-подходы стимулируют открытие скрытых взаимосвязей в данных, но требуют строгой оценки качества, симуляций и участия человека верификации на всех этапах.

Недавняя публикация в журнале Artificial Intelligence показывает, что LLM рассматриваются как элементы, перестраивающие научный метод — от обзора литературы до проектирования экспериментов и обнаружения закономерностей в данных. В обзоре подчеркивается, что глубокая интеграция моделей в научный цикл требует совместной работы человека и машины, согласованных метрик качества и прозрачных критериев оценки.

Повышение эффективности работы с литературой — еще одно направление, уже подтвержденное эмпирически. Новая методика автоматической генерации обзоров на основе LLM демонстрирует, что автоматизированные обзоры по сотням научных публикаций могут достигать уровня качества, сравнимого или превосходящего ручной анализ, с пруф-валидацией и очень низким уровнем ошибок (менее 0,5 % ложных утверждений).

Практическое применение LLM в научных задачах выходит за рамки текстовой аналитики. Специализированные модели и гибридные системы все чаще используются для задач структурного и функционального предсказания объектов науки — например, предсказания трехмерной структуры белков, что существенно сокращает время исследований в биологии и медицине. DeepMind уже продемонстрировал такие возможности в серии моделей, включая AlphaFold и его новые версии, которые предсказывают структуры белков с очень высокой достоверностью, тем самым открывая путь к новым открытиям в молекулярной биологии.

Также появляются новые агентные системы, которые ориентированы на полный цикл научного исследования — от поиска литературы до проектирования экспериментов и анализа результатов в полуавтономном режиме. Эти системы еще находятся на стадии активного развития, но уже показывают, что LLM могут стать ядром будущей автоматизации научной методологии.

Исследования подчеркивают, что, несмотря на прорывы, LLM остаются уязвимыми к проблемам качества данных, ограниченной интерпретируемости и риску «галлюцинаций» — особенно в высокоточных научных приложениях. Поэтому современные подходы включают:

структурированные знания и графы для контроля вывода;

инструментальную интеграцию с симуляциями и базами данных;

обязательное участие экспертов на этапах проверки результатов.

Именно такие гибридные модели и многоуровневые рабочие процессы становятся доминирующей практикой в научных исследованиях, позволяя использовать мощь LLM без потери строгости научного метода.

Несмотря на стремительное развитие LLM, сохранится ряд фундаментальных ограничений, которые будут сдерживать их универсальное применение. Даже самые продвинутые языковые модели не станут полностью автономными и самодостаточными системами. Их эффективность по-прежнему будет напрямую зависеть от качества данных, архитектуры внедрения и уровня человеческого контроля.

Одним из ключевых ограничений останется контекст. Языковые модели не «понимают» мир в человеческом смысле, а оперируют вероятностными связями. Это означает, что в нестандартных или слабо формализуемых ситуациях модель может демонстрировать уверенные, но ошибочные выводы. Особенно остро это проявляется там, где генерирование решений связано с этикой, ответственностью или юридическими последствиями.

Дополнительным вызовом станет масштабирование. По мере того как все больше компаний уже используют LLM в критически важных системах, возрастает нагрузка на инфраструктуру, требования к вычислительным ресурсам и сложность поддержки. Попытки глубоко внедрить LLM в устаревшие ИТ-среды нередко приводят к снижению эффективности и росту операционных рисков.

Ещё одним существенным ограничением останется зависимость от качества и полноты данных. Даже при применении корпоративных источников, объемы знаний модели будут уязвимы к неполноте, искажениям и устареванию информации. Это делает необходимым постоянный аудит и обновление контекста, без чего надежность решений быстро падает.

К числу ключевых ограничений ближайших лет уже сейчас относятся:

Ограниченность контекста;

Недостаточность ресурсов;

Трудности контроля;

Вопросы ответственности.

В итоге будущее LLM представляется не как путь к абсолютному искусственному интеллекту, а развитие мощного, но ограниченного инструмента, эффективность которого определяется качеством среды и зрелостью его применения. Важно вовремя и правильно управлять данными процессами, умело их разворачивать для повышения качества и результата задуманного.

Большие языковые модели перейдут от экспериментальных решений к полноценным инструментам инфраструктуры бизнеса, науки и технологий. Они станут не просто генераторами текста, а системными компонентами, глубоко интегрированными в трудовые процессы и поддерживающими принятие обоснованных решений на основе актуальных данных.

Галлюцинации перестанут быть критическим ограничением благодаря использованию проверенных объемов хранилищ и продуманной архитектуры решений. Вместо традиционного файн-тюнинга модели будут адаптироваться через плагины, контекст и подключение специализированных данных.

Ключевым фактором успеха станет безопасность, которая включает:

- строгий контроль доступа к данным и ресурсам;

- прозрачность работы моделей и механизма принятия решений;

- возможность интеграции LLM в корпоративную среду без риска нарушений информационной безопасности.

Развитие виртуальных агентов продолжается, они постепенно берут на себя выполнение множества задач и взаимодействие с различными системами без постоянного контроля человека.

Таким образом, можем с уверенностью сказать, что будущее LLM несет в себе сочетание надежности, гибкости и интеграции в реальные процессы. А их ценность определяется не только интеллектом модели, но и качеством данных и среды применения.